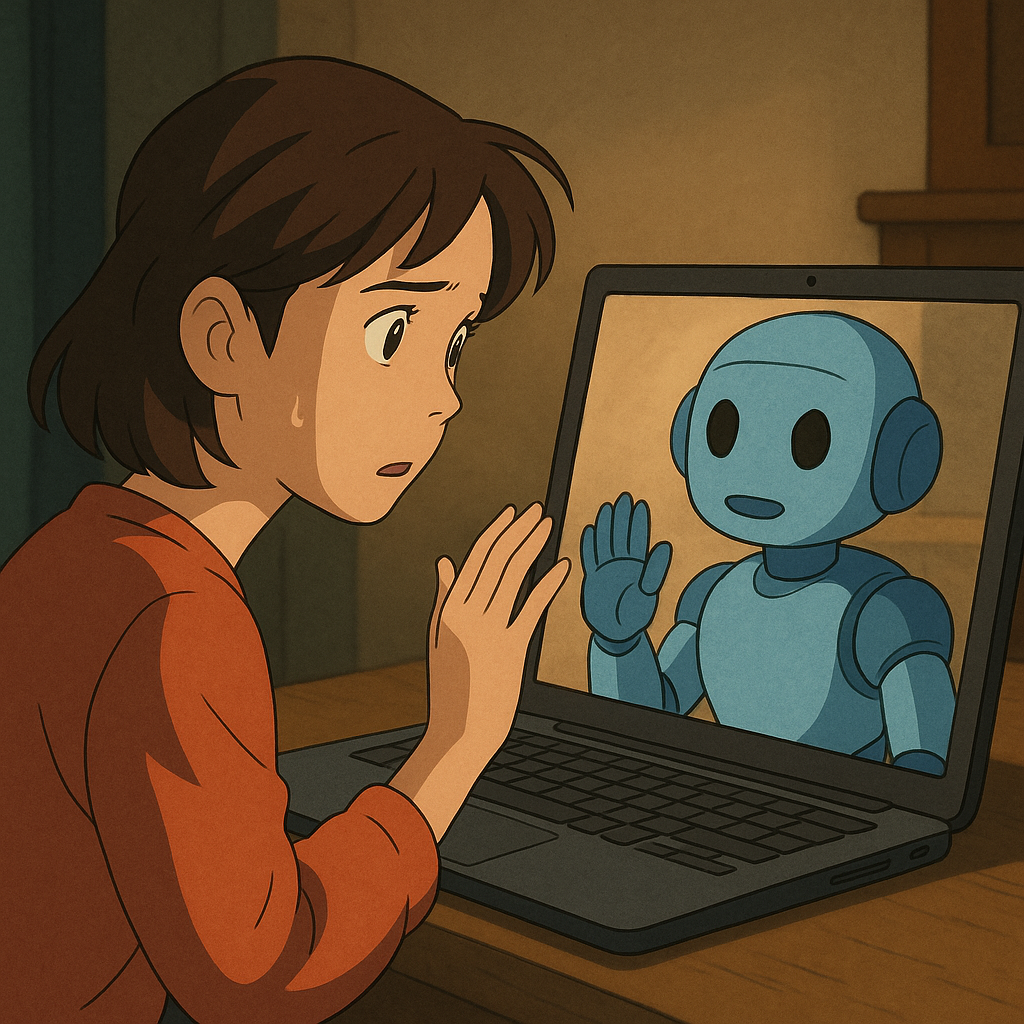

قابلیت جدید تصویرسازی بهسبک انیمیشنهای استودیو جیبلی که اخیراً در ابزار تولید تصویر ChatGPT فعال شده، با استقبال زیادی در شبکههای اجتماعی مواجه شده است. این ویژگی که از تاریخ ۲۶ مارس در دسترس قرار گرفته، به کاربران امکان میدهد هنگام چت با هوش مصنوعی عکسهای خود را به تصاویری با حالوهوای انیمیشنهای جیبلی تبدیل کنند. بااینحال، در کنار جذابیت ظاهری، این قابلیت بار دیگر مشکلات حریم خصوصی در ChatGPT را پررنگ کرده است.

در تاریخ ۳۰ مارس و حوالی ساعت ۴ بعدازظهر، افزایش ناگهانی استفاده از این ابزار منجر به اختلال در عملکرد سرورهای ChatGPT شد؛ اما آنچه بیش از این اختلال فنی اهمیت دارد، هشدارهایی است که کارشناسان امنیت سایبری درباره خطرات احتمالی این ویژگی مطرح کردهاند. به گفته آنها، گسترش استفاده از این ابزار میتواند زمینهساز سوءاستفاده از تصاویر شخصی کاربران شود.

در این مقاله، نگاهی دقیقتر به قابلیت موسوم به «جیبلی» خواهیم داشت و خطرات بارگذاری تصاویر در ChatGPT را بررسی میکنیم. این مقاله به ایرانیان کمک میکند تا بهتر متوجه شوند که چرا ChatGPT برای حریم خصوصی خطرناک است؟ آیا بارگذاری عکس در ChatGPT امن است؟

مشکلات حریم خصوصی در ChatGPT هنگام استفاده از قابلیت جیبلی

چت با هوش مصنوعی آنلاین و رایگان گوگل بسیار رایج است. اما اکنون قابلیت ویرایش عکس هم به آن اضافه شده است. مشکلات حریم خصوصی در ChatGPT که به آپلود عکسهای شخصی در این چت بات مرتبط است شامل موارد زیر است.

1. جمعآوری دادههای شخصی و متادیتا

هنگام بارگذاری تصاویر در ربات هوشمند ChatGPT، کاربران ممکن است بهطور ناخواسته دادههای حساس را به OpenAI منتقل کنند. این دادهها شامل متادیتای موجود در فایلهای تصویری (EXIF) مانند زمان گرفتهشدن عکس، مختصات GPS محل عکسبرداری، و اطلاعات دستگاه مانند نوع دستگاه، سیستمعامل، نسخه مرورگر و شناسههای منحصربهفرد است. علاوهبر این، اطلاعات رفتاری مانند نوع درخواستهای واردشده، تعاملات با رابط کاربری و فرکانس این تعاملات نیز جمعآوری میشود که همگی بهشیوه زیر از جمله مشکلات حریم خصوصی در ChatGPT محسوب میشوند.

- نشت اطلاعات حساس: متادیتا میتواند اطلاعات شخصی مانند مکان دقیق کاربر یا الگوهای رفتاری را فاش کند، که ممکن است توسط هکرها یا اشخاص ثالث مورد سوءاستفاده قرار گیرد.

- استفاده برای پروفایلسازی: دادههای جمعآوریشده میتوانند برای ایجاد پروفایلهای دقیق از کاربران استفاده شوند. این امر خطر سوءاستفادههای تجاری یا حتی فعالیتهای مخرب را افزایش میدهد.

- عدم شفافیت: OpenAI بهطور کامل مشخص نکرده است که چگونه این دادهها ذخیره، پردازش یا استفاده میشوند، که این موضوع نگرانیهایی درباره حریم خصوصی ChatGPT ایجاد میکند.

2. استفاده از تصاویر برای آموزش مدلهای هوش مصنوعی

تصاویر بارگذاریشده توسط کاربران هنگام چت با هوش مصنوعی گوگل ممکن است برای بهبود مدلهای هوش مصنوعی OpenAI، بهویژه مدلهای چندوجهی که به ورودیهای بصری وابستهاند، استفاده شوند. این روند بهویژه در ترندهای ویروسی مانند ایجاد تصاویر به سبک استودیو جیبلی یا فیگورهای اکشن مشخص است. OpenAI با این قابلیتها کاربران را تشویق میکند تصاویر شخصی خود را بارگذاری کنند؛ آن هم بدون برطرفساختن مشکلات حریم خصوصی در ChatGPT.

استفاده از تصاویر برای آموزش مدلهای هوش مصنوعی میتواند با خطرات زیر همراه باشد.

- نقض حریم خصوصی توسط ChatGPT: تصاویر شخصی ممکن است بدون رضایت صریح کاربر برای آموزش مدلها استفاده شوند، که این امر میتواند شامل دادههای بیومتریک مانند چهره باشد.

- عدم امکان حذف کامل دادهها: حتی اگر کاربران بخواهند دادههای خود را حذف کنند، ممکن است تصاویر آنها قبلاً در فرآیندهای آموزشی استفاده شده باشند. این نشانی از مشکلات حریم خصوصی در ChatGPT است.

- دادههای متنوع و گسترده: این ترندها به OpenAI امکان میدهند دادههای تصویری متنوعی از گروههای سنی، قومیتها و مناطق جغرافیایی مختلف جمعآوری کند. این امر قدرت مدلهای آنها را افزایش میدهد، اما به قیمت نقض حریم خصوصی کاربران توسط .ChatGPT

3. خطرات نقض کپیرایت

قابلیتهای تولید تصویر این چت بات chatbot، مانند ایجاد تصاویر بهسبک استودیو جیبلی، نگرانیهایی درباره نقض کپیرایت ایجاد کرده است. مدلهای هوش مصنوعی ممکن است با استفاده از آثار دارای کپیرایت برای آموزش، بدون کسب مجوز، قوانین را نقض کنند.

این مشکل از مشکلات حریم خصوصی در ChatGPT میتواند با خطرات زیر همراه باشد:

- مسائل قانونی: شکایتهای اخیر، مانند شکایت نیویورک تایمز علیه OpenAI در دسامبر ۲۰۲۴، نشاندهنده مشکلات قانونی مرتبط با استفاده از محتوای دارای کپیرایت است.

- تأثیر بر هنرمندان: استفاده از آثار هنری برای آموزش مدلها بدون جبران خسارت میتواند به هنرمندان و خالقان محتوا آسیب برساند.

- عدم شفافیت در منابع آموزشی: OpenAI درباره منابع دادههای آموزشی خود شفافیت کافی ندارد. این موضوع اعتماد کاربران را کاهش داده و از مشکلات حریم خصوصی در ChatGPT محسوب میشود.

4. آسیبپذیریهای امنیتی و سوءاستفاده

زیرساخت چت بات هوش مصنوعی ChatGPT ممکن است در برابر حملات سایبری مانند جعل درخواست سمت سرور (SSRF) آسیبپذیر باشد، که میتواند کاربران را به URLهای مخرب هدایت کند. علاوهبر این، چت بات های هوش مصنوعی مانند ChatGPT میتوانند از طریق مهندسی سریع (prompt engineering) دستکاری شوند و برای اهداف مخرب استفاده شوند. این مسئله پایهای مهم برای مشکلات حریم خصوصی در ChatGPT فراهم میسازد که با خطرات زیر همراه است.

- دسترسی غیرمجاز: حملات SSRF میتوانند به دسترسی غیرمجاز به دادهها یا سیستمهای دیگر منجر شوند.

- سوءاستفاده از تصاویر: تصاویر بارگذاریشده ممکن است در معرض سوءاستفاده قرار گیرند، بهویژه اگر شامل اطلاعات قابلشناسایی مانند اسناد یا پسزمینههای حساس باشند.

- دستکاری محتوا: بازیگران مخرب میتوانند از قابلیتهای تحلیل تصویر برای ایجاد محتوای جعلی یا گمراهکننده استفاده کنند.

5. عدم وضوح در قوانین حریم خصوصی و دادههای بیومتریک

درحالیکه در برخی مناطق مانند اتحادیه اروپا و بریتانیا، قوانین سختگیرانهای مانند GDPR برای حفاظت از دادههای بیومتریک وجود دارد، در ایالات متحده قوانین متفاوت و گاه ناکافی هستند. سیاست حفظ حریم خصوصی OpenAI بهطور خاص به دادههای بیومتریک یا شباهتهای چهره اشاره نمیکند. این موضوع میتواند زمینه را برای سوءاستفادههای غیرقانونی فراهم سازد.

عدم وضوح در قوانین حریم خصوصی و دادههای بیومتریک میتواند بهشکل زیر نگرانیهایی درباره حریم خصوصی ChatGPT ایجاد کند.

- عدم حمایت قانونی کافی: در مناطقی مانند ایران که قوانین حریم خصوصی چندان مشخص نیست و تحریمها بر کشور فشار وارد میکند، کاربران ممکن است در برابر سوءاستفاده از دادههایشان آسیبپذیر باشند.

- استفاده طولانیمدت از تصاویر: تصاویر بارگذاریشده هنگام استفاده از چت بات ممکن است برای مدت طولانی ذخیره شده یا برای اهدافی مانند پروفایلسازی استفاده شوند؛ بدون اینکه کاربران بتوانند آنها را بهطور کامل حذف کنند.

- مسئولیت کاربر: OpenAI تأکید میکند که کاربران مسئول محتوای بارگذاریشده هستند. این امر خطر بارگذاری تصاویر دیگران بدون رضایت را افزایش داده و از مشکلات تولید عکس و چت با هوش مصنوعی گوگل محسوب میشود.

بهطور کلی و خلاصه میتوان گفت مشکلات حریم خصوصی در ChatGPT هنگام استفاده از قابلیت جیبلی شامل موارد زیر است:

- نقض حریم خصوصی: احتمال استفاده بدون اجازه از عکسهای کاربران برای اهداف مختلف (مثل آموزش هوش مصنوعی)

- سرقت هویت: امکان سوءاستفاده از اطلاعات فردی توسط افراد سودجو

- تهدیدات امنیتی: احتمال دسترسی هکرها به اطلاعات کاربران

- ساخت پروفایلهای جعلی: استفاده از تصاویر برای ایجاد هویتهای دروغین در فضای مجازی

- پیامدهای حقوقی: استفاده نامناسب از تصاویر ممکن است باعث مشکلات قانونی برای کاربران شود.

نظر افراد برجسته درباره قابلیت «جیبلی» و مشکلات حریم خصوصی در ChatGPT

سم آلتمن، مدیرعامل OpenAI، درباره قابلیت استودیو جیبلی ChatGPTمیگوید: «امروز ویژگی جدیدی را در ChatGPT معرفی میکنیم: تصاویر در چت! … این یک فناوری خارقالعاده است. یادم هست وقتی برای اولین بار چند تصویر از این مدل دیدم، باورش برایم سخت بود که واقعاً توسط هوش مصنوعی ساخته شدهاند. ما فکر میکنیم مردم آن را دوست خواهند داشت و بیصبرانه منتظر دیدن خلاقیتهایی هستیم که بهواسطه آن شکل میگیرند.»

اگرچه این قابلیت محبوبیت بسیار زیادی در بین مردم پیدا کرده است و کمتر کسی را میتوانید پیدا کنید که از آن استفاده نکرده باشد، اما برخی از افراد سرشناس، نظراتی منفی درباره آن دادهاند که میتواند نشانهای از مشکلات حریم خصوصی در ChatGPT باشد. در ادامه برخی از این نظرات را آوردهایم.

لویزا یاروسکی، همبنیانگذار aitechprivacy.com، در ایکس میگوید:

«بیشتر مردم هنوز متوجه نشدهاند که افکت گیبلی (Ghibli Effect) فقط یک بحث حقوقی در حوزه کپیرایت هوش مصنوعی نیست، بلکه ترفند روابط عمومی OpenAI برای دسترسی به هزاران تصویر شخصی جدید هم هست.»

همچنین او در پستی چنین میگوید:

«هزاران نفر اکنون داوطلبانه تصاویر چهره و عکسهای شخصی خود را در ChatGPT بارگذاری میکنند. در نتیجه، OpenAI بهطور رایگان و آسان به هزاران چهره جدید دسترسی پیدا میکند تا مدلهای هوش مصنوعی خود را آموزش دهد… وقتی افراد این تصاویر را بهصورت داوطلبانه بارگذاری میکنند، به OpenAI اجازه پردازش آنها را میدهند (طبق بند ۶.۱.a از مقررات عمومی حفاظت از دادههای اتحادیه اروپا – GDPR). این مبنای قانونی متفاوتی است که آزادی بیشتری به OpenAI میدهد…..OpenAI بهراحتی و بدون هزینه به این تصاویر دسترسی پیدا میکند، و فقط خود این شرکت نسخههای اصلی را در اختیار خواهد داشت.»

هایائو میازاکی، همبنیانگذار استودیو گیبلی، در جلسهای در سال ۲۰۱۶ که انیمیشن ساختهشده با هوش مصنوعی به او نشان داده شد:

«کسی که چنین چیزهایی میسازد، هیچ درکی از رنج ندارد. من واقعاً منزجر شدهام. اگر واقعاً میخواهید چیزهای ترسناک بسازید، مختارید. اما من هرگز دلم نمیخواهد چنین فناوری را وارد کارم کنم. بهشدت احساس میکنم که این توهینی است به خود زندگی.»

چگونه از حریم خصوصی در ChatGPT محافظت کنیم؟

برای جلوگیری از مشکلات حریم خصوصی در ChatGPT لازم است نحوه گفتوگو با هوش مصنوعی را کنترل کرده و اقدامات زیر را هنگام تولید عکس بهکار برید تا از خطرات قابلیت جیبلی در ChatGPT در امان باشید.

- حذف متادیتا از تصاویر: قبل از بارگذاری، با استفاده از ابزارهای ویرایش عکس، متادیتا (EXIF) را از تصاویر حذف کنید.

- استفاده از تصاویر غیرشخصی: به جای تصاویر واقعی، از آواتارهای دیجیتالی یا تصاویری با فیلترهای سنگین استفاده کنید.

- خاموشکردن تاریخچه چت: در تنظیمات ChatGPT، گزینه تاریخچه چت را غیرفعال کنید تا از استفاده دادههایتان برای آموزش جلوگیری شود.

- بررسی تنظیمات حریم خصوصی: تنظیمات حساب OpenAI خود را بررسی کنید و گزینههای مربوط به استفاده از دادهها برای آموزش مدلها را غیرفعال کنید.

- اجتناب از بارگذاری تصاویر حساس: از بارگذاری تصاویری که شامل اطلاعات قابلشناسایی مانند اسناد، افراد دیگر یا پسزمینههای خاص هستند، خودداری کنید.

- عدم استفاده از ابزارهای شخص ثالث: از ابزارهای شخص ثالث غیرمعتبر برای ویرایش یا بارگذاری تصاویر استفاده نکنید.

- آگاهی از سیاستهای حریم خصوصی: قبل از بارگذاری تصاویر، سیاستهای حریم خصوصی OpenAI را بهدقت مطالعه کنید.

خلاصه مقاله

در مجموع، قابلیت جدید تصویرسازی بهسبک انیمیشنهای جیبلی در ChatGPT اگرچه با استقبال کاربران مواجه شده، اما زنگ خطر مهمی برای حفظ حریم خصوصی به صدا درآورده است و مشکلات حریم خصوصی در ChatGPT را نشان میدهد. بارگذاری تصاویر شخصی کاربران، بدون شفافیت کافی در سیاستهای حریم خصوصی OpenAI، زمینهساز نگرانیهای جدی درباره جمعآوری دادههای حساس، استفاده از آنها برای آموزش مدلهای هوش مصنوعی، خطرات امنیتی، و حتی نقض قوانین کپیرایت و دادههای بیومتریک شده است. عدم وضوح در سیاستها و نبود کنترل کاربر بر سرنوشت دادههایش، این قابلیت را به بستری برای نقض حریم خصوصی توسط ChatGPT بدل کرده که میتواند پیامدهای حقوقی و اخلاقی گستردهای بههمراه داشته باشد.

سوالات رایج درباره مشکلات حریم خصوصی در ChatGPT

سوال: آیا ChatGPT تصاویر من را ذخیره میکند؟

پاسخ: بله، OpenAI ممکن است تصاویر بارگذاریشده را طبق سیاست حریم خصوصی خود ذخیره و برای بهبود مدلهای هوش مصنوعی استفاده کند. برای جلوگیری، تنظیمات استفاده از دادهها را غیرفعال کنید.

سوال: چگونه متادیتا را از تصاویر حذف کنم؟

پاسخ: با استفاده از ابزارهای ویرایش عکس مانند Photoshop یا اپلیکیشنهای رایگان مثل ExifCleaner، متادیتا (EXIF) را قبل از بارگذاری حذف کنید. این کار اطلاعات حساس مانند مکان را پاک میکند.

سوال: آیا بارگذاری تصاویر در ChatGPT امن است؟

پاسخ: بارگذاری تصاویر میتواند خطراتی مانند نقض حریم خصوصی یا سوءاستفاده از دادهها را به همراه داشته باشد. از تصاویر غیرشخصی استفاده کنید و تنظیمات حریم خصوصی را بررسی کنید.

منابع مقاله:

ChatGPT’s Ghibli Edit Raises Privacy Concerns

ChatGPT’s Image Generator Can Create Action Figures—and Privacy Problems